任務調度中消息處理的優化策略及其在數據處理服務中的應用

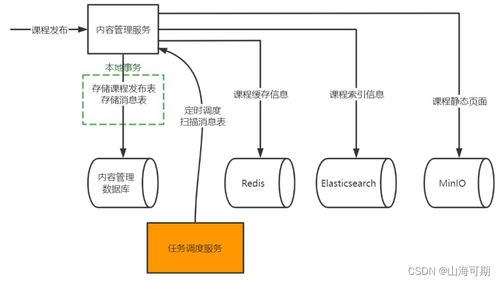

在當今的數據驅動時代,數據處理服務已成為企業運營的核心組成部分。任務調度作為協調和執行這些數據處理任務的關鍵機制,其效率與可靠性直接影響到整個系統的性能。消息處理則是任務調度的中樞神經系統,負責指令的傳遞、狀態的同步和錯誤的協調。因此,設計一套高效、健壯的消息處理解決方案,對于構建高性能的數據處理服務至關重要。

一、 消息處理在任務調度中的核心挑戰

在復雜的分布式數據處理環境中,任務調度面臨諸多挑戰:

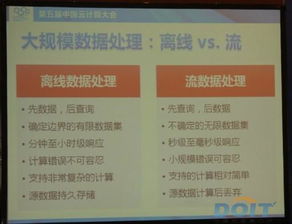

- 高并發與吞吐量:海量數據需要被實時或近實時處理,系統需同時調度成千上萬的任務,消息隊列面臨巨大的寫入和讀取壓力。

- 可靠性與一致性:必須保證任務指令不丟失、不重復,且處理狀態在分布式節點間保持一致。任何消息的丟失或重復都可能導致數據處理錯誤或資源浪費。

- 順序性與依賴管理:許多數據處理任務之間存在嚴格的先后順序或依賴關系(如A任務的輸出是B任務的輸入),消息處理需要保證這種順序得到正確維護。

- 容錯與故障恢復:當某個處理節點或消息中間件本身發生故障時,系統應能快速檢測、隔離故障,并恢復或重新調度受影響的任務,保證數據處理的最終一致性。

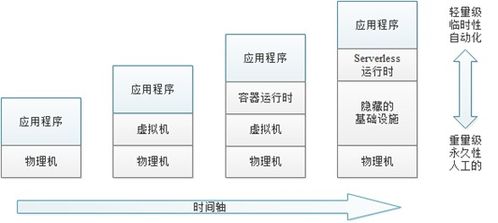

- 可伸縮性與彈性:數據處理負載往往存在波峰波谷,消息處理架構需要能夠水平擴展以應對負載增長,并在負載降低時釋放資源。

二、 主流的消息處理解決方案

針對上述挑戰,業界形成了幾種成熟的消息處理模式與技術選型:

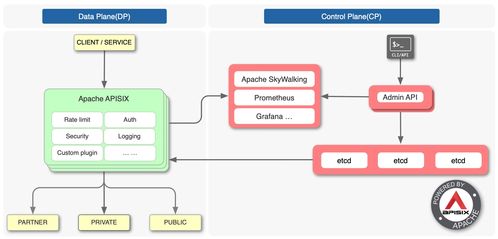

- 基于消息隊列的異步解耦模式

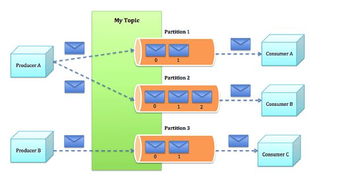

- 核心思想:將任務調度器(生產者)與任務執行器(消費者)通過消息隊列(如RabbitMQ, Apache Kafka, Apache Pulsar, RocketMQ)解耦。調度器將任務封裝成消息發送至隊列,執行器監聽并拉取消息進行處理。

- 優勢:

- 緩沖與削峰:隊列能積壓瞬時高峰請求,保護后端處理服務。

- 異步性:調度器無需等待任務執行完畢,提高了整體吞吐量和響應速度。

- 解耦:生產者和消費者可獨立演進和擴展。

- 在數據處理服務中的應用:常用于ETL流水線、流式計算任務的分發。Kafka因其高吞吐、持久化、分區順序性等特點,特別適合作為大規模流處理任務的消息總線。

- 基于發布/訂閱(Pub/Sub)的主題模式

- 核心思想:當任務狀態變更(如“完成”、“失敗”)或需要廣播某些控制指令(如“全局暫停”)時,調度器或執行器向特定主題發布消息,所有關心該事件的服務訂閱并消費。

- 優勢:實現了系統內事件的一對多廣播,便于實現事件驅動的架構,使狀態跟蹤、日志聚合、監控報警等組件能輕松集成。

- 在數據處理服務中的應用:用于實時通知任務執行進度、觸發下游依賴任務、更新全局儀表盤等。

- 基于工作流引擎的協調模式

- 核心思想:使用如Apache Airflow, DolphinScheduler, Cadence/Temporal等工作流引擎。它們內置了強大的調度器、執行器和狀態機,通過持久化存儲(通常是數據庫)來管理任務狀態和依賴關系,其內部通信本質也是一種可靠的消息傳遞。

- 優勢:

- 可視化與可編程:提供DAG(有向無環圖)定義任務流,依賴關系清晰,支持復雜業務流程。

- 自帶重試、回溯、告警:簡化了容錯邏輯的開發。

- 在數據處理服務中的應用:非常適合管理有復雜依賴關系的批處理作業,如每日的數據倉庫ETL流程、機器學習模型訓練流水線等。

三、 優化實踐與關鍵策略

- 消息設計與序列化:采用高效且兼容性好的序列化協議(如Protocol Buffers, Avro),壓縮消息體積。消息體應包含任務ID、類型、參數、優先級、創建時間及必要的上下文信息。

- 保證消息可靠投遞:

- 生產者端:啟用消息中間件的確認機制(如Kafka的acks=all,RabbitMQ的publisher confirm),確保消息持久化到Broker。

- 消費者端:采用“至少一次”或“恰好一次”語義。在“至少一次”語義下,消費者必須在成功處理業務邏輯后手動提交偏移量,并保證處理邏輯的冪等性(如通過業務唯一鍵校驗),以應對可能的重復消費。

- 處理順序與依賴:對于需要嚴格順序的任務,可利用消息隊列的分區(Partition)或順序隊列特性,將具有相同順序鍵的任務發送到同一分區。工作流引擎則天然通過DAG管理依賴。

- 容錯與監控:

- 死信隊列(DLQ):將多次重試失敗的消息轉入DLQ,供人工或自動程序分析處理,避免堵塞主流程。

- 完備的監控:實時監控消息隊列的堆積長度、消費延遲、錯誤率等關鍵指標,并設置報警閾值。

- 優雅的重試與退避:消費者處理失敗時,應有帶指數退避的重試策略,避免在瞬時故障下雪崩。

- 彈性伸縮:根據隊列堆積長度或系統負載指標,動態擴縮容消費者(任務執行器)實例數量。這在云原生環境下通過與Kubernetes HPA等工具結合可以輕松實現。

四、

任務調度中的消息處理是數據處理服務的“經絡”。通過合理選擇消息中間件、采用異步解耦架構、并結合工作流引擎管理復雜依賴,可以構建出高并發、高可靠、易擴展的數據處理平臺。成功的核心在于深入理解業務的數據流和SLA要求,在消息的可靠性、順序性、延遲和吞吐量之間做出恰當的權衡,并輔以完善的監控與容錯機制,從而確保海量數據能夠被高效、準確地轉化為業務價值。

如若轉載,請注明出處:http://m.harry5.cn/product/36.html

更新時間:2026-02-21 10:39:18